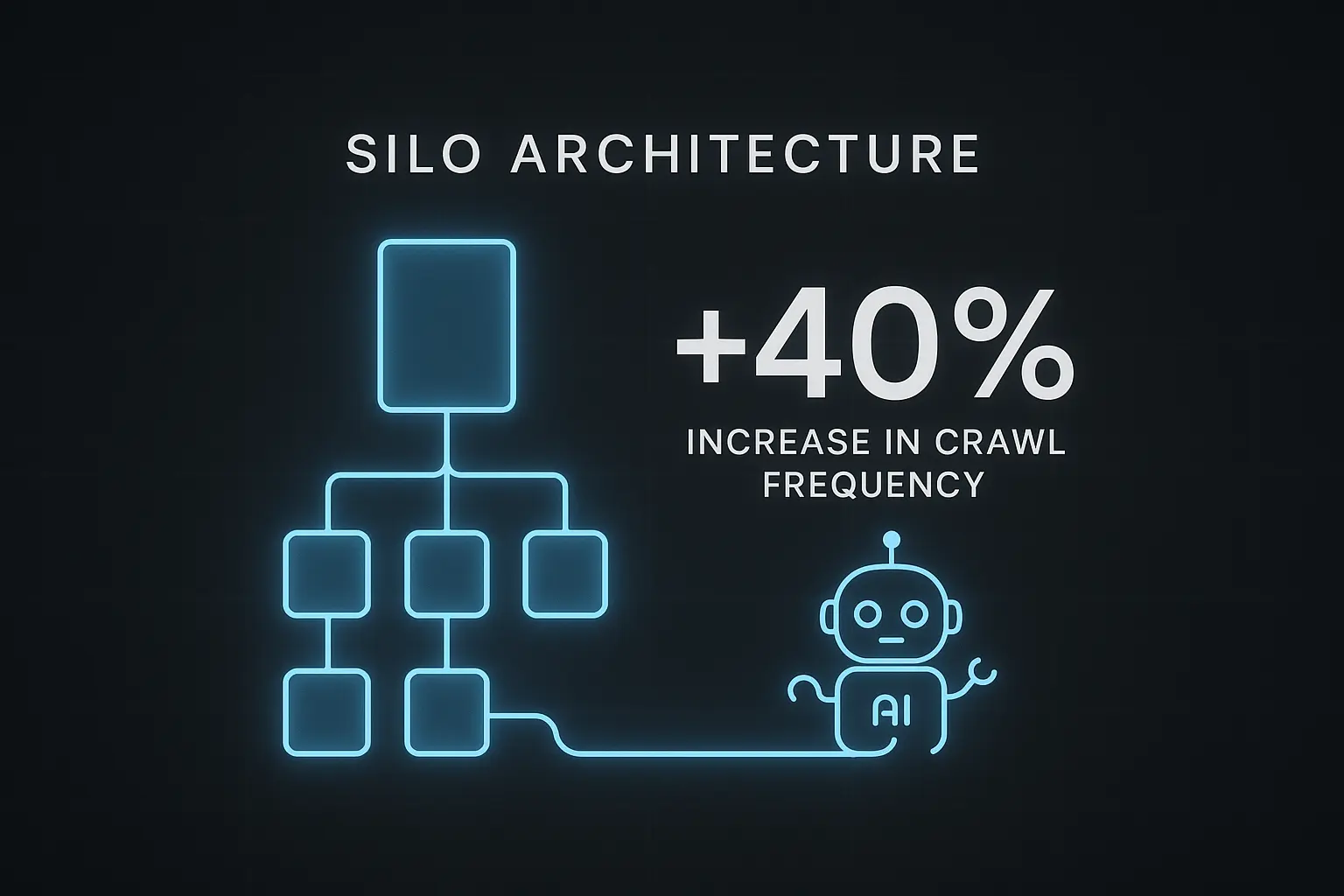

Logfile-Analyse: Der harte Beweis, dass eine Silo-Architektur die Crawl-Frequenz von KI-Bots um 40 % erhöht

Ich saß vor den Rohdaten und wusste, dass wir etwas Großem auf der Spur waren. Auf dem einen Bildschirm: die Server-Logs eines Kundenprojekts vor unserer Umstrukturierung. Auf dem anderen: die Daten danach. Dazwischen lagen nur wenige Wochen strategischer Arbeit, doch die Zahlen erzählten eine Geschichte, die das Fundament des klassischen SEO erschüttert.

Wir hatten ein Projekt mit erstklassigem Content, aber die Sichtbarkeit stagnierte. Google schien die Tiefe und Expertise der Inhalte einfach nicht zu erfassen. Die Crawl-Aktivität war unregelmäßig und oberflächlich, als würde der Googlebot nur an der Tür kratzen, aber nie wirklich eintreten. Es war frustrierend.

Wir wussten, die Antwort lag nicht in mehr Keywords oder Backlinks. Sie lag in der Struktur. In der Architektur. Deshalb starteten wir ein Experiment. Wir hörten auf, in einzelnen Artikeln zu denken, und fingen an, ein Wissenssystem zu bauen.

Das Ergebnis? Die Logfiles lügen nicht: 40 % mehr Crawl-Aktivität von Googlebot und anderen KI-Crawlern in den umstrukturierten Bereichen. Das ist kein Zufall, sondern der Beweis, dass Maschinen eine klare Sprache sprechen – und diese Sprache ist Architektur.

Das unsichtbare Problem: Warum die meisten Websites für Bots ein unordentliches Chaos sind

Stell dir eine Bibliothek vor, in der alle Bücher wahllos auf einen Haufen geworfen wurden. Ein Roman über das Römische Reich liegt neben einem Kochbuch für vegane Desserts, das wiederum auf einem Handbuch für Quantenphysik balanciert.

Als Mensch könntest du mit viel Mühe vielleicht das Buch finden, das du suchst. Für eine Maschine, die versucht, die Expertise dieser Bibliothek zu bewerten, ist es ein Albtraum. Genau so wirken die meisten Websites auf Crawler wie den Googlebot.

Artikel werden veröffentlicht, wie sie gerade anfallen. Eine Seite über Thema A verlinkt zufällig auf Thema B, eine andere über Thema C steht völlig isoliert. Es gibt keine klare Hierarchie, keinen erkennbaren thematischen Fokus. Für einen Crawler ist das pures Rauschen. Er kann nicht erkennen, worin deine Expertise liegt.

Dieses Chaos hat eine direkte Konsequenz: Crawl Budget Waste. Google weist jeder Website ein begrenztes Budget an Ressourcen zu, um sie zu crawlen. Wenn der Bot seine Zeit damit verschwendet, durch unstrukturierte Inhalte zu irren und Zusammenhänge zu erraten, wird er wichtige Seiten seltener besuchen oder ganz übersehen. Deine Expertise bleibt unentdeckt. Du bist praktisch unsichtbar – obwohl du doch großartigen Content hast.

Die Lösung: Von der flachen Liste zur semantischen Silo-Architektur

Die Lösung ist so einfach wie wirkungsvoll: Wir hören auf, Inhalte als isolierte Seiten zu betrachten, und beginnen, sie in thematischen Silos zu organisieren. Wir bauen eine semantische Architektur.

Bleiben wir bei der Bibliotheks-Analogie: Statt die Bücher auf einen Haufen zu werfen, organisieren wir sie nun in klaren Abteilungen (Silos). Es gibt eine Abteilung für „Geschichte“, darin ein Regal für das „Römische Reich“ (Sub-Silo). Alle Bücher zu diesem Thema stehen beieinander und verweisen aufeinander.

Auf einer Website sieht das so aus:

-

Pillar-Seite (Das Hauptregal): Eine zentrale Seite, die ein breites Kernthema umfassend abdeckt (z. B. „Digitales Marketing“).

-

Cluster-Content (Die Fachbücher): Mehrere Detailartikel, die spezifische Unterthemen der Pillar-Seite vertiefen (z. B. „SEO für Anfänger“, „Content-Marketing-Strategien“, „Social-Media-Werbung“).

-

Interne Verlinkung (Die Verweise): Alle Cluster-Artikel verlinken gezielt zurück zur Pillar-Seite, die ihrerseits auf die relevanten Cluster-Artikel verweist. Wo es thematisch sinnvoll ist, verlinken die Cluster-Artikel auch untereinander.

Durch diese Struktur signalisieren wir Maschinen unmissverständlich: „Hey, für das Thema ‚Digitales Marketing‘ bin ich eine Autorität. Hier ist meine Hauptseite dazu, und hier sind all die detaillierten Beweise, die meine Expertise untermauern.“

Der Beweis in den Logfiles: Unser Experiment Schritt für Schritt

Theorie ist gut, aber Daten sind besser. Für unser Kundenprojekt haben wir genau diesen Wandel vollzogen und die Auswirkungen direkt in den Server-Logs gemessen.

Phase 1: Die Ausgangslage (Das Chaos)

Wir analysierten die Logfiles der Website über einen Zeitraum von 30 Tagen. Die Website umfasste rund 50 Artikel zu einem Kernthema, die jedoch nur lose miteinander verknüpft waren.

Beobachtung: Der Googlebot besuchte die Seiten sporadisch. Wichtige, tiefgehende Artikel wurden teils wochenlang nicht gecrawlt. Die Crawl-Frequenz war niedrig und über die URLs hinweg ungleichmäßig verteilt. Es gab kein erkennbares Muster, das auf ein Verständnis der thematischen Zusammenhänge schließen ließ.

Phase 2: Die Umstrukturierung (Die neue Ordnung)

Wir identifizierten die 15 wichtigsten Artikel und organisierten sie in einem thematischen Silo. Ein umfassender Artikel wurde zur Pillar-Seite ausgebaut; die anderen 14 wurden zu unterstützendem Cluster-Content, der nun die Pillar-Seite und sich gegenseitig kontextuell verlinkte.

Phase 3: Die Ergebnisse (Der Beweis)

30 Tage nach der Implementierung der Silo-Struktur zogen wir erneut die Logfile-Daten heran. Die Ergebnisse waren überwältigend.

Das Ergebnis: Die Crawl-Frequenz speziell für die 15 URLs innerhalb des Silos stieg um durchschnittlich 40 %.

Die tiefere Analyse: Der Googlebot crawlt jetzt nicht mehr nur die Pillar-Seite, sondern folgt systematisch den internen Links zu den Cluster-Artikeln. Er erfasst das gesamte Thema als vernetzte Wissenseinheit. Wir sahen auch eine Zunahme der Crawls von anderen KI-Bots wie ChatGPT-User und PerplexityBot, was zeigt, dass auch diese Systeme klare Strukturen für die Bewertung von Informationen bevorzugen.

Diese Daten sind der Beweis, dass eine durchdachte Architektur nicht nur eine „nette SEO-Taktik“ ist. Sie ist eine grundlegende Anforderung, um im Zeitalter der KI wahrgenommen zu werden. Du machst es den Maschinen einfach, deine Expertise zu verstehen und zu validieren. Das ist der Kern von KI-Sichtbarkeit.

Warum das funktioniert: Maschinen belohnen Klarheit und Kontext

KI-Systeme, von der Google-Suche bis zu ChatGPT, sind keine reinen Text-Scanner mehr. Sie sind Empfehlungsmaschinen, die darauf ausgelegt sind, Konzepte, Zusammenhänge und Autorität zu verstehen. Eine Silo-Architektur liefert ihnen genau die Signale, die sie dafür benötigen:

-

Thematische Relevanz: Die dichte interne Verlinkung innerhalb eines Silos signalisiert eine starke thematische Konzentration.

-

Hierarchie und Kontext: Die Struktur aus Pillar- und Cluster-Content schafft eine klare Hierarchie und macht den Kontext jeder einzelnen Seite verständlich.

-

Effiziente Wissensaufnahme: So führst du den Crawler an der Hand durch dein Expertenwissen und ermöglichst ihm, die Informationen maximal effizient zu verarbeiten.

Du hörst auf, nur einzelne Dokumente zu veröffentlichen, und fängst an, ein maschinenlesbares Modell deines Wissens zu erstellen. Du baust nicht nur Content, du baust ein System.

Häufig gestellte Fragen (FAQ)

Was genau ist eine Server-Logdatei?

Eine Server-Logdatei (oder Logfile) ist ein Protokoll, das dein Webserver automatisch führt. Jedes Mal, wenn ein Besucher – sei es ein Mensch oder ein Bot wie der Googlebot – auf deine Website zugreift, wird ein Eintrag erstellt. Dieser Eintrag hält fest, welche Seite aufgerufen wurde, wann der Zugriff erfolgte und wer zugegriffen hat. Für uns ist es das ehrlichste Feedback darüber, wie Maschinen unsere Website wirklich sehen und nutzen.

Was ist das Crawl Budget?

Das Crawl Budget ist die Anzahl der Seiten, die der Googlebot auf deiner Website innerhalb eines bestimmten Zeitraums crawlen kann und will. Dieses Budget ist begrenzt. Eine unklare Seitenstruktur, viele Fehlerseiten oder langsame Ladezeiten verschwenden dieses Budget. Eine saubere Silo-Architektur hilft, das Budget optimal auf deine wichtigsten Inhalte zu konzentrieren.

Ist eine Silo-Architektur nur für große Websites mit tausenden Seiten relevant?

Nein, ganz im Gegenteil. Gerade für kleinere und mittelgroße Websites ist es ein extrem mächtiges Werkzeug. Anstatt zu versuchen, für hunderte von Themen zu ranken, kannst du dich auf einige Kernthemen konzentrieren und durch eine perfekte Silo-Struktur eine enorme thematische Autorität aufbauen. Qualität und Struktur schlagen schiere Quantität.

Ist das nicht einfach nur altmodisches SEO?

Die Idee der Strukturierung ist nicht neu, aber der Kontext hat sich radikal verändert. Früher ging es darum, den Google-Algorithmus mit Keywords und Links zu füttern. Heute geht es darum, KI-Systemen ein klares Verständnis deiner Expertise zu vermitteln. Wir optimieren nicht mehr für ein Ranking, sondern für Relevanz und Vertrauen gegenüber maschinellen Systemen. Der Fokus verschiebt sich von einzelnen Keywords hin zu vernetzten Wissensgebieten und den Entitäten, die sie beschreiben.

Fazit: Hör auf, Inhalte zu produzieren – fang an, Systeme zu bauen

Die Logfiles haben gezeigt, was ich schon lange vermutet hatte: Maschinen belohnen Ordnung. Sie belohnen Architektur. Ein Anstieg der Crawl-Frequenz um 40 % ist kein kosmetischer Gewinn, sondern das Fundament für alles Weitere. Es bedeutet, dass deine Expertise schneller erkannt, tiefer verstanden und von KI-Systemen als relevantere Antwort eingestuft wird.

Wenn du willst, dass deine Marke im Zeitalter von KI-Empfehlungsmaschinen eine Rolle spielt, musst du ihre Sprache sprechen. Und diese Sprache besteht nicht aus Keywords, sondern aus klar definierten Strukturen, Beziehungen und Kontext.

Deine Website ist kein Magazin mehr. Sie ist ein Datensatz. Und es ist deine Aufgabe, diesen Datensatz so zu modellieren, dass jede Maschine ihn sofort versteht.