Semantische Distanz: Wie ich aufhörte zu raten und lernte, thematische Relevanz zu messen

Ich erinnere mich genau an das Projekt. Wir hatten eine perfekte Content-Struktur, dachte ich. Ein zentraler Pillar-Artikel, umgeben von detaillierten Sub-Artikeln. Alles logisch verknüpft, sauber recherchiert. Ein Paradebeispiel für den Aufbau von Topical Authority. Doch die KI-Systeme ignorierten die Verbindung. Ein Artikel rankte, während der andere unsichtbar blieb. Für den menschlichen Leser war der Zusammenhang glasklar, aber für die Maschine existierte er nicht.

Das Problem war eine unsichtbare Lücke. Eine Lücke, die man nicht mit Keyword-Tools findet. Man entdeckt sie nur, wenn man anfängt, die Sprache der Maschinen zu sprechen – die Sprache der Mathematik. Es war der Moment, in dem ich aufhörte, über Relevanz zu spekulieren, und begann, sie zu messen: mit der semantischen Distanz.

Warum Ihr Bauchgefühl für Content-Strukturen nicht mehr ausreicht

Jahrelang haben wir uns auf unser Gespür verlassen. Wir haben Themencluster gebildet, weil sie sich „richtig anfühlten“. Wir haben interne Links gesetzt, weil es „logisch“ erschien. Dieses Vorgehen hat in der Ära der reinen Keyword-Optimierung vielleicht noch ausgereicht. Aber diese Ära ist vorbei.

Heute leben wir im Zeitalter der semantischen Suche. Spätestens seit Googles Hummingbird-Update geht es nicht mehr darum, welche Wörter auf einer Seite stehen, sondern darum, welche Konzepte und Beziehungen diese Wörter repräsentieren. KI-Systeme wie Google oder ChatGPT lesen keine Keywords mehr – sie interpretieren Bedeutung. Sie denken in Entitäten, also in klar definierten Objekten wie Personen, Orten oder Konzepten, und deren Verbindungen zueinander.

Das bedeutet: Wenn zwei Artikel für eine Maschine thematisch nicht erkennbar zusammengehören, existiert diese Verbindung schlichtweg nicht. Ihr mühsam aufgebautes Wissensnetz hat ein Loch.

Hier kommt die semantische Distanz ins Spiel. Sie ist keine Esoterik, sondern eine harte, messbare Metrik. Sie quantifiziert, wie weit zwei Inhalte konzeptionell voneinander entfernt sind.

![Eine Visualisierung von zwei weit entfernten Punkten in einem Vektorraum, beschriftet mit ‚Artikel A‘ und ‚Artikel B‘ und einer gestrichelten Linie ‚Hohe semantische Distanz‘]()

Stellen Sie sich eine riesige Bibliothek vor. Jeder Text ist ein Punkt in einem multidimensionalen Raum. Texte, die über ähnliche Konzepte sprechen, liegen nah beieinander. Texte mit wenig thematischer Überschneidung liegen weit auseinander. Die Entfernung zwischen diesen Punkten ist die semantische Distanz.

Eine große Distanz bedeutet, dass die KI keine relevante Verbindung sieht. Eine geringe Distanz signalisiert: „Diese Inhalte ergänzen sich, sie gehören zusammen, sie bilden ein umfassendes Bild zu einem Thema.“ Unser Ziel muss es also sein, diese Distanz für zusammengehörige Inhalte systematisch zu verringern.

Mein Prozess: Semantische Nähe in 4 Schritten berechnen

Die gute Nachricht ist: Wir müssen nicht mehr raten. Wir können diese Distanz berechnen. Die technologische Grundlage dafür sind sogenannte Vektor-Embeddings. Dabei wird Text in eine Kette von Zahlen (einen Vektor) umgewandelt, der seine semantische Bedeutung repräsentiert. Modelle wie BERT oder Word2Vec sind darauf trainiert, diese Vektoren so zu erstellen, dass ähnliche Konzepte auch mathematisch ähnliche Vektoren erhalten.

Sobald wir diese Vektoren haben, können wir mit einer Metrik namens Cosinus-Ähnlichkeit (Cosine Similarity) den „Winkel“ zwischen zwei Texten berechnen. Das Ergebnis ist ein Wert zwischen -1 und 1.

- 1: Die Texte sind semantisch identisch.

- 0: Es gibt keine semantische Beziehung.

- -1: Die Texte sind semantisch das exakte Gegenteil.

Für die Content-Analyse bewegen wir uns meist zwischen 0 und 1. Mein Prozess, um diese Werte zu ermitteln und praktisch zu nutzen, ist erstaunlich gradlinig.

![Eine schematische Darstellung des Prozesses: URL 1 + URL 2 -> Text-Extraktion -> Vektor-Embeddings -> Cosinus-Ähnlichkeit Score]()

Schritt 1: Die Kandidaten identifizieren

Ich wähle zwei URLs aus, die eine starke thematische Beziehung haben sollten. Meistens ist das ein Hauptartikel (Pillar) und ein unterstützender Detailartikel (Cluster). Beispiel: Ein Artikel über „KI-Sichtbarkeit“ und ein anderer über „Entitäten für Anfänger“.

Schritt 2: Text extrahieren und bereinigen

Ich extrahiere den reinen Fließtext beider Artikel. Dafür entferne ich alle Navigationselemente, Footer oder Werbebanner, die das Signal verfälschen könnten. Entscheidend ist allein der redaktionelle Inhalt, der das eigentliche Wissen transportiert.

Schritt 3: Vektorisierung der Inhalte

Der bereinigte Text wird nun durch ein Sprachmodell geschickt, das für jeden Artikel ein Vektor-Embedding erzeugt. Dies ist der entscheidende Schritt, bei dem Wörter und Sätze in ihre mathematische Repräsentation umgewandelt werden. Ich nutze dafür meist Python-Bibliotheken wie sentence-transformers, aber es gibt auch zugänglichere Tools, die diesen Prozess vereinfachen.

Schritt 4: Ähnlichkeit berechnen und interpretieren

Zuletzt berechne ich die Cosinus-Ähnlichkeit der beiden Vektoren. Das Ergebnis ist ein klarer Score, zum Beispiel 0.65. Dieser Wert bildet nun meine Arbeitsgrundlage. Ein Wert unter 0.7 ist für mich oft ein Warnsignal, dass eine konzeptionelle Brücke fehlt. Ein Wert über 0.8 signalisiert eine starke thematische Kopplung.

Aus Daten werden Handlungen: Ein Beispiel aus der Praxis

Theorie ist gut, aber erst die Anwendung schafft den „Aha-Moment“. Bei einem Kundenprojekt analysierten wir einen zentralen Artikel über „Markenaufbau im Mittelstand“ und einen unterstützenden Artikel über „Reputationsmanagement online“. Unser Bauchgefühl sagte: Die gehören eng zusammen.

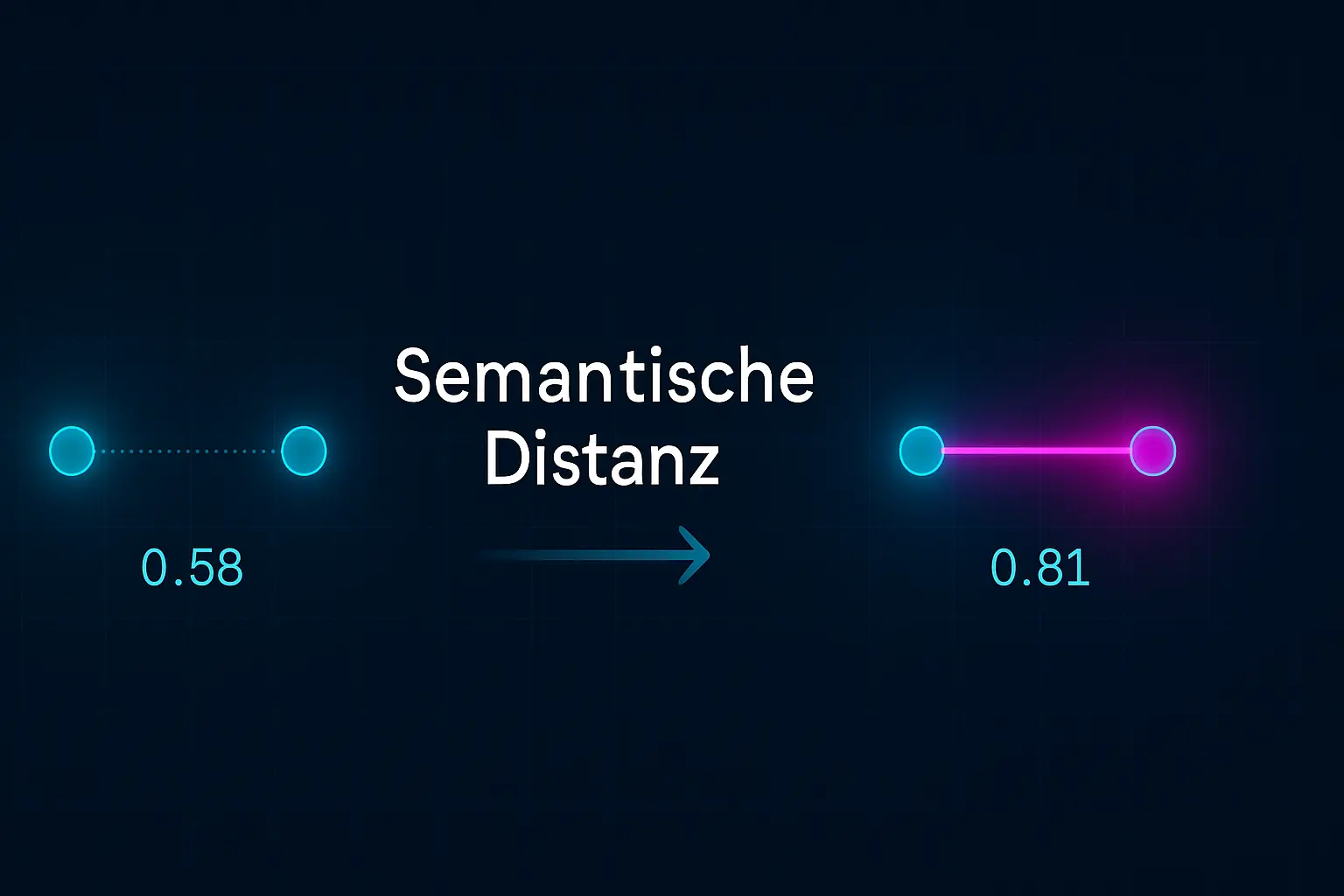

Die Messung ergab eine Cosinus-Ähnlichkeit von 0.58. Ein erschreckend niedriger Wert.

Die Analyse der Inhalte zeigte das Problem: Der Artikel zum Markenaufbau sprach ausschließlich über klassische Strategien wie Logo, Wording und Corporate Identity. Der Artikel zum Reputationsmanagement fokussierte sich auf Online-Bewertungen und Social-Media-Monitoring. Es fehlte die entscheidende Brücke: wie digitale Reputation direkt die Wahrnehmung und damit den Wert einer Marke beeinflusst.

Also handelten wir gezielt:

-

Wir ergänzten im Artikel „Markenaufbau“ einen Absatz, der die digitale Reputation als zentralen Pfeiler moderner Markenführung definiert.

-

Wir fügten im Artikel „Reputationsmanagement“ einen Abschnitt hinzu, der den Bogen zurück zur übergeordneten Markenstrategie spannt.

Nach der Anpassung wiederholten wir die Messung. Das neue Ergebnis: 0.81.

![Eine Visualisierung von zwei nahen Punkten im Vektorraum, beschriftet ‚Artikel A‘ und ‚Artikel B (optimiert)‘, Linie ‚Geringe semantische Distanz‘]()

Wir haben nicht einfach ein paar Keywords hinzugefügt. Wir haben eine konzeptionelle Lücke geschlossen. Wir haben der Maschine explizit gezeigt, wie diese beiden Themen zusammenhängen. Das Ergebnis war nicht nur ein höherer Score, sondern eine spürbar bessere Performance des gesamten Themenclusters in den Wochen danach. Das ist die eigentliche Macht einer datengestützten Entitäten-Architektur.

Häufig gestellte Fragen (FAQ)

Was ist der Unterschied zwischen semantischer Ähnlichkeit und Keyword-Dichte?

Keyword-Dichte zählt, wie oft ein bestimmtes Wort vorkommt. Sie ist eine rein statistische und oberflächliche Metrik. Semantische Ähnlichkeit analysiert die Bedeutung und den Kontext ganzer Textabschnitte. Ein Text über „Apfel“ (Frucht) und „Apple“ (Unternehmen) hätte eine geringe semantische Ähnlichkeit, obwohl das Keyword dasselbe ist.

Brauche ich dafür Programmierkenntnisse?

Für eine tiefe, individuelle Analyse sind Grundkenntnisse in Python hilfreich. Allerdings kommen zunehmend Tools und Plattformen auf den Markt, die diese Analyse zugänglicher machen.

Wichtiger als das Programmieren selbst ist jedoch das Verständnis des Konzepts, um die Ergebnisse richtig zu deuten und die richtigen Schlüsse zu ziehen.

Welcher Wert für die Cosinus-Ähnlichkeit ist „gut“?

Das hängt vom Kontext ab. Für einen Pillar-Artikel und einen sehr spezifischen Sub-Artikel erwarte ich Werte zwischen 0.75 und 0.85. Zu hohe Werte (über 0.9) können auf thematische Kannibalisierung hindeuten, bei der zwei Artikel praktisch dasselbe aussagen. Es geht um die perfekte Balance aus Nähe und Eigenständigkeit.

Hilft die Optimierung der semantischen Distanz auch für die Sichtbarkeit in ChatGPT & Co.?

Absolut. KI-Chatbots und Antwortmaschinen funktionieren nach denselben Prinzipien. Sie suchen nach den präzisesten und am besten vernetzten Wissensquellen, um ihre Antworten zu generieren. Ein engmaschiges, semantisch kohärentes Wissensnetz macht Ihre Inhalte zu einer idealen Quelle für Zitate und Referenzen in KI-generierten Antworten.

Fazit: Bauen Sie keine Seiten, bauen Sie Wissensnetze

Die Messung der semantischen Distanz hat meine Herangehensweise an Content-Strategie fundamental verändert. Sie zwingt uns, über die reine Seitenebene hinauszudenken und stattdessen in vernetzten Wissensmodellen zu arbeiten.

Wir hören auf, Inhalte als isolierte Dokumente zu betrachten, und fangen an, sie als Knoten in einem Graphen zu sehen. Unsere Aufgabe ist es nicht mehr, einzelne Knoten zu optimieren, sondern die Verbindungen zwischen ihnen so stark und logisch wie möglich zu machen.

Kontext ist keine Magie, sondern Mathematik. Wer aufhört, über Relevanz zu spekulieren, und anfängt, semantische Beziehungen zu messen, baut die zukunftsfähigen Wissensarchitekturen, die in der Ära der Empfehlungsmaschinen nicht nur überleben, sondern dominieren werden.